Cap. 2 - Corso Base Fotografia Digitale

Un sensore di immagini tipo CCD. Qui sotto un disegno che rappresenta un ingrandimento dei suoi pixel, ognuno dei quali cattura una porzione dell'immagine finale.

Come si può notare, i pixel verdi sono in numero doppio rispetto ai rossi e ai blu. Infatti i nostri occhi sono più sensibili al colore verde, che quindi deve essere riprodotto con maggiore accuratezza.

La grande differenza fra le camere analogiche e quelle digitali consiste nel modo in cui la luce viene catturata. Al posto della pellicola fotosensibile, le fotocamere digitali usano un dispositivo elettronico allo stato solido chiamato sensore di immagini di tipo CCD (Charge-Coupled Device) o CMOS (Complementary Metal Oxide Semiconductor). Sulla superficie di questi chip di silicio di varie dimensioni, si trova una griglia di milioni di diodi fotosensibili, detti fotoelementi o più comunemente pixel (picture element). Ogni singolo fotoelemento cattura la luminosità ed il colore di una minima porzione dell'intera immagine. Il disegno rappresenta una porzione ingrandita della superficie del sensore. Si può notare che i pixel verdi sono in numero doppio rispetto ai rossi e ai blu. Infatti i nostri occhi sono più sensibili al colore verde, che quindi deve essere riprodotto con maggiore accuratezza.

L'esposizione

Quando si preme il pulsante per scattare una foto, una cellula fotoelettrica (esposimetro) misura la quantità di luce che entra nella camera attraverso le lenti, determinando il valore di apertura del diaframma e della velocità di otturazione per ottenere una corretta esposizione. In questo istante ogni pixel del sensore registra la brillantezza della luce che lo colpisce, accumulando una carica elettrica. Più intensa è la luce, più alta sarà la carica elettrica. Alla chiusura del diaframma, la carica di ogni pixel viene misurata ed il suo valore viene convertito in un numero binario (digitale). La serie di numeri ottenuta viene elaborata dal software della camera per ricostruire l'immagine sul monitor della camera e memorizzarla nella scheda di memoria.

Vista in trasparenza di una tipica reflex, senza l'obiettivo. Quando il diaframma si apre, la luce arriva al sensore di immagini. Ogni singolo pixel registra l'intensità della luce che lo colpisce, il colore verrà in seguito elaborato ed aggiunto dal software di controllo.

Solo bianco e nero

Potrà sembrare sorprendente, ma i pixel del sensore possono registrare solo l'intensità della luce, non il suo colore. Ogni singolo pixel colpito dalla luce può produrre una scala di 256 valori che corrispondono a 256 tonalità di grigio, dal puro nero al puro bianco. Come la fotocamera riesca a ricreare un'immagine colorata partendo dal bianco-nero, è una storia molto interessante che vedremo più avanti.

La scala dei grigi comprende 256 tonalità, dal puro nero al puro bianco. L'immagine con 32 tonalità è solo indicativa.

Come nasce il colore nella fotografia digitale

Quando fu inventata, la fotografia poteva essere solo in bianco e nero. La ricerca per riprodurre il colore fu un processo lungo e difficile, e per molti decenni il colore veniva applicato a mano sulle lastre esposte.

Il primo vero passo verso la ricostruzione del colore fu compiuto nel 1860 dal fisico scozzese James Clerk Maxwell che per primo usò un negativo in bianco e nero e tre filtri in rosso, verde e blu. Fece scattare dal fotografo Thomas Sutton tre foto di un oggetto colorato, ognuna con un diverso filtro applicato davanti all'obiettivo. Le tre immagini furono proiettate su uno schermo con tre diversi proiettori, ognuno con lo stesso filtro usato per le riprese.

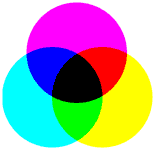

Quando le tre immagini furono perfettamente sovrapposte, il risultato fu la prima vera immagine ottica a colori. Quasi un secolo e mezzo più tardi, i sensori di immagini funzionano secondo lo stesso principio. Tutti i colori di un'immagine fotografica hanno origine dai tre colori primari, Rosso, Verde, Blu (RGB). Quando i tre colori primari sono combinati nella stessa intensità, si ottiene luce bianca.

Il sistema additivo RGB è usato tutte le volte che la luce viene proiettata per formare i colori su uno schermo, o direttamente nei nostri occhi. Per essere più corretti, dobbiamo precisare che il sistema RGB viene usato quando si tratta di miscelare luce, come nel monitor del nostro PC o schermo TV, mentre nei processi di stampa si usa il sistema sottrattivo CMY perché si tratta di miscelare pigmenti da applicare su una superficie bianca.

In questo caso i colori primari usati sono Cyan (turchese), Magenta (violetto) e Yellow (giallo), che possono produrre tutte le sfumature di tutti i colori se miscelati in varie proporzioni. In teoria, se miscelati in uguali proporzioni, dovrebbero produrre il nero. In realtà produrrebbero un colore indefinito bruno-grigio-scuro. Per questo motivo, per riprodurre fedelmente i toni scuri, nelle nostre stampanti fotografiche è presente anche un serbatoio di inchiostro nero fotografico.

Per riassumere, il sistema additivo (RGB) crea i colori aggiungendo luce ad uno sfondo nero, mentre il sistema sottrattivo (CYM) usa pigmenti per bloccare selettivamente la luce riflessa da uno sfondo bianco

Il sistema additivo RGB (Red-Green-Blue) è usato per i monitor e la TV.

Il sistema additivo RGB (Red-Green-Blue) è usato per i monitor e la TV.

I colori aggiungono luce ad uno sfondo nero

Se si sovrappongono i tre colori primari additivi di eguale intensità, si forma il bianco. Con la sovrapposizione di due colori si formano rispettivamente i colori cyano giallo e magenta (CYM).

ll sistema sottrattivo CYM (Cyan-Yellow-Magenta) è usato per la stampa. I pigmenti sottraggono luce ad uno sfondo bianco.

ll sistema sottrattivo CYM (Cyan-Yellow-Magenta) è usato per la stampa. I pigmenti sottraggono luce ad uno sfondo bianco.

Se si sovrappongono i tre colori primari sottrattivi di eguale intensità, si forma il nero. Con la sovrapposizione di due colori si formano rispettivamente rosso, verde e blu (RGB).

Dal Bianco/Nero al Colore

Poiché la luce solare bianca è composta dai tre colori di base, basta mettere un filtro rosso, o verde o blu, sopra ogni pixel per scomporre la luce nei tre canali di colore e ottenere immagini colorate, esattamente come fece Maxwell nel 1860. Nel sistema Bayer usato nella maggior parte dei sensori, i filtri verdi sono in numero doppio degli altri. Poiché l'occhio umano è molto più sensibile al verde che agli altri due colori, l'esatta resa cromatica del verde è più importante.

Le micro-lenti al di sopra dei filtri colorati servono a focalizzare la luce e aumentare la resa del sensore. Filtri colorati ricoprono ogni pixel del sensore. I filtri verdi sono in numero doppio rispetto ai filtri rossi e blu. Ogni pixel registra solo la luce del colore del suo filtro, quindi il 50% dei pixel "vedono" solo la luce verde, il 25% solo la luce rossa, il 25% solo la luce blu, come illustrato dal disegno seguente.

Il sistema RGB è certamente il più diffuso, ma non il solo. Altri sistemi usano la combinazione di colori sottrattivi CMY (Cyan-Magenta-Yellow), oppure CYGM (Cyan-Yellow-Green-Magenta), o la variante introdotta da Sony RGBE (Emerald). Ogni sistema ha i suoi vantaggi e punti deboli, i tentativi di migliorare la resa cromatica sono costanti. Da notare che la fedeltà dei colori riprodotti dipende in gran misura dalla perfezione dell'algoritmo del software, il vero motore che sta alla base della ricostruzione delle immagini digitali.

L'interpolazione cromatica

Con i filtri colorati, ogni pixel registra la brillantezza della luce colorata che passa attraverso il proprio filtro, mentre gli altri colori vengono bloccati. Per esempio, un pixel con filtro rosso percepisce solo la luce rossa che lo colpisce, ma se su quel pixel arriva luce di un altro colore, rimane spento. Occorre quindi determinare di quale colore quel pixel dovrebbe essere. Usando come riferimento i colori dei pixel circostanti, l'algoritmo stabilisce quale colore attribuire ai pixel che non registrano direttamente alcun segnale.

Il ragionamento (semplificato) è il seguente: Se in una certa area arriva luce rossa, tutti i pixel con filtro rosso saranno attivi mentre i pixel verdi e blu saranno spenti. In questo caso il software deciderà che tutti i pixel in quell'area devono essere rossi ed attribuirà il colore rosso anche ai pixel spenti.

In pratica, ogni pixel misura l'intensità di uno dei colori primari, se questo colore è presente nella luce incidente. Se invece quel pixel non percepisce luce, il suo colore viene "stimato" dal software basandosi sul colore degl otto pixel adiacenti. Per eseguire questo processo in modo ottimale, è necessaria una mole impressionante di calcoli, dato che in realtà per ogni pixel si esegue il confronto con i suoi otto vicini.

Questo processo (interpolazione cromatica o interpolazione Bayer) richiede un notevole dispendio di energia, che significa consumo delle batterie e rallentamento delle operazioni, ma comporta anche alti costi di sviluppo del software e di produzione dei microchip. Per tutti questi motivi nelle camere compatte si usano algoritmi relativamente semplici, con conseguente inferiore livello della qualità delle immagini.

C'è un computer nella tua camera

Ogni volta che si scatta una foto, milioni di operazioni vengono eseguite in un istante. Sono questi calcoli che rendono possibile catturare, convertire, elaborare, comprimere, memorizzare, visualizzare in anteprima, trasferire, e riprodurre l'immagine. Tutti questi calcoli vengono effettuati da un microprocessore all'interno della fotocamera (foto a destra), simile a quello del nostro computer. La sola differenza è costituita dalla potenza di calcolo, necessariamente limitata nelle fotocamere per motivi spazio, di costi, e di consumo energetico. La grande differenza tra camere compatte e camere reflex, oltre alle dimensioni del sensore, sta appunto nella potenza di calcolo del processore.

Tipi di sensore

Per molti anni, i sensori tipo CCD (Charge-Coupled Device) erano gli unici sensori usati nelle fotocamere, avendo raggiunto un buon grado di sviluppo in anni di impiego in telescopi ottici, scanner, videocamere ecc. Ora però si sta affermando un nuovo tipo di sensore, il CMOS (Complementary Metal Oxide Semiconductor) che promette di diventare il sensore di prima scelta in un vasto segmento del mercato. Sia i sensori CCD che i CMOS catturano la luce in una griglia di pixel, ma differiscono quanto a processi di produzione e per il metodo di elaborazione e gestione delle immagini.

I sensori CCD

Il sensore CCD deve il suo nome alla modalità di lettura dei pixel. Dopo l'esposizione, le cariche elettriche della prima riga in basso vengono trasferite in una sezione del sensore chiamata registro di lettura. Da qui, i segnali sono inviati ad un amplificatore e poi ad un particolare circuito che converte i valori analogici in dati digitali.

Finita la lettura della prima riga, le sue cariche nel registro di lettura vengono azzerate, tutte le altre righe scendono di un posto ed il processo riprende fino alla lettura dell'ultima riga. Le cariche di ogni riga sono "accoppiate" (coupled) a quelle della riga soprastante, così quando una riga si sposta in basso la successiva prende il suo posto. In questo modo le righe possono essere lette ed elaborate una alla volta.

I sensori CMOS

Il grande problema dei sensori CCD è di carattere economico, dato che i volumi di produzione non consentono soddisfacenti economie di scala, considerati i colossali investimenti necessari. Gli impianti di produzione sono altamente specializzati, cioè sono adatti solo alla produzione di CCD. Mentre invece i sensori CMOS sono prodotti nelle stesse fabbriche e con le stesse attrezzature usate per fabbricare i milioni di microchip impiegati ormai ovunque come processori per computer o memorie.

Il processo di produzione CMOS è di gran lunga il più comune ed economico e usare lo stesso processo e le stesse attrezzature per produrre sensori di immagine taglia i costi di circa un terzo, rispetto ai costi dei CCD. Costi che sono ulteriormente ridotti dal fatto che i CMOS contengono i circuiti di processo delle immagini nello stesso chip, mentre nel caso dei CCD tali circuiti devono essere alloggiati in un chip separato.

Se i sensori CMOS delle prime versioni erano afflitti da problemi di "rumore digitale" ed erano impiegati in fotocamere a basso costo, ora grandi progressi sono stati compiuti e le loro prestazioni in termini di qualità delle immagini sono paragonabili a quelle dei CCD, tanto da essere impiegati in alcune fra le migliori camere di livello professionale. Uno dei grandi vantaggi dei CMOS è l'alta velocità di elaborazione delle immagini che consente la ripresa di molte foto in poco tempo.

La risoluzione del sensore

Come abbiamo visto, con il termine risoluzione si intende la capacità di un'immagine di rendere i dettagli. I sensori presenti nelle fotocamere di primo livello hanno una risoluzione intorno ai 9-15 milioni di pixel, anche se il numero tende ad aumentare. Le camere di alto livello hanno dai 15 a 20 milioni di pixel, mentre gli apparecchi professionali vantano oltre i 24 milioni di pixel. Può sembrare impressionante, ma anche queste ultime cifre non sono paragonabili ai 120 milioni di recettori che si stima siano presenti nei nostri occhi.

Come ci si può aspettare, i costi aumentano proporzionalmente alla risoluzione, a parità degli altri fattori. L'alta risoluzione però comporta altri problemi. Per esempio più pixel significa file più grandi, più spazio occupato in memoria, maggiore difficoltà di editing, e maggiore potenza di calcolo richiesta sia nelle fotocamere che nei computer.

- Risoluzioni minori come 800 x 600 sono perfette per la pubblicazione sul Web, allegati di e-mail, piccole stampe, o immagini in documenti e presentazioni. Per tali usi una maggiore risoluzione significa solo maggiori dimensioni dei file senza migliorare la qualità delle immagini in modo significativo.

- Alte risoluzioni (8-12 milioni di pixel e oltre), sono più adatte per la stampa di ingrandimenti foto-realistici di dimensioni 20x30 cm o maggiori.

La Kodak dichiara che con circa 1 milione di pixel si ottengono stampe foto-realistiche da 18x12 cm. Tuttavia un numero maggiore di pixel comporta anche più dettaglio e colori più brillanti. Per stampe fino a 32x40 cm si hanno buoni risultati con 5 megapixel ed in alcuni casi le stampe sono superiori a quelle basate su film. In parte ciò si spiega col fatto che le stampe a basso costo e prodotte in serie da negativi sono spesso orribili. Al loro confronto le stampe digitali sembrano opere d'arte.